应用安全的盲点与热点:AI安全

随着AI(人工智能)技术引爆点的到来,AI安全风险快速累积,已经成为应用安全的新盲点和新热点。

AI正在吃掉世界

硅谷大佬们曾经常挂在嘴边的一句话是:“软件正在吃掉世界”,如今,随着ChatGPT为首的大语言模型人工智能的降临,人工智能市场突飞猛进,“AI正在吃掉软件(世界)”已经成了业界的共识。

几乎是一夜之间,从内容创作者到大型科技公司的首席执行官,每个人都空前卖力地自发炒作人工智能话题。原因很简单,人工智能已经展现出了掀起一场新的工业革命的潜力。

虽然近日美国上千名科技精英和技术专家联名签署公开信,呼吁全球所有AI实验室未来六个月内暂停开发比GPT-4更强大的(接近通用人工智能的)AI系统,以避免当前AI风险控制和“对齐”能力滞后导致的“对社会和人类的深远风险”。但是ChatGPT发动的AI技术革命已经无法关闭和暂停,至少对于黑客和网络犯罪分子如此。

毫无疑问,每个人、每家公司,都将在未来几年内成为人工智能的重度用户。但是有一个重要问题被大多数人忽视了,那就是(企业内部部署和训练的)人工智能应用也带来了许多网络安全团队没有意识到的新风险。

应用安全的新热点:AI安全

就像几十年前应用安全是传统网络防火墙的盲点,针对人工智能的攻击也是当下应用安全的盲点,或者说,新命题。

针对AI的攻击原理

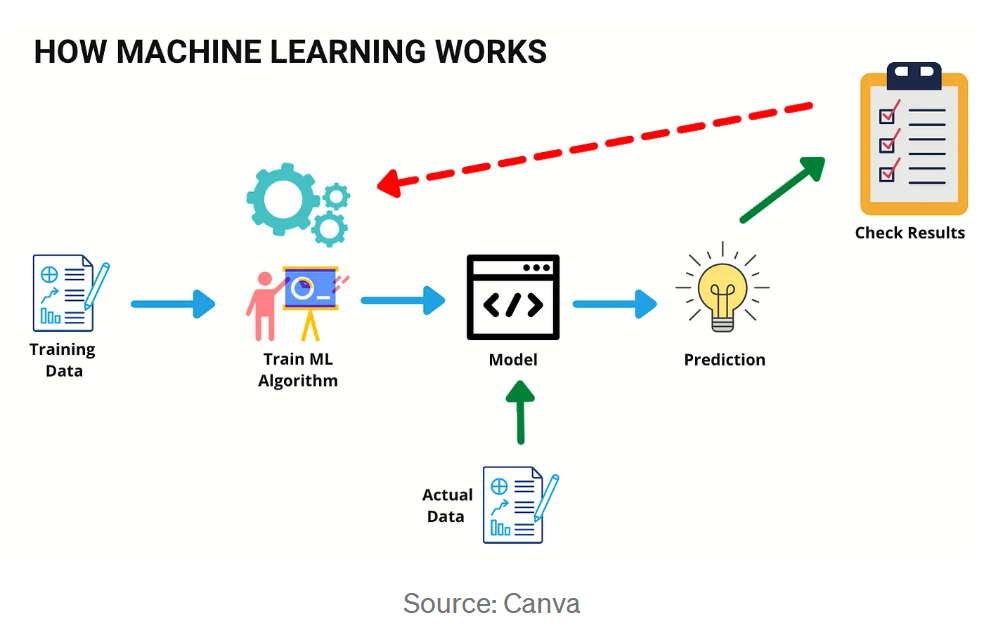

对AI的攻击往往会针对机器学习的工作方式。机器学习是人工智能的引擎,机器学习模型从训练数据中学习,并建立基于这些数据做出决策的能力。

最初,模型可能会犯错误,这些错误会根据实际数据进行检查并用于对其进行微调。你提供给模型的数据越多,随着时间的推移,它就越准确。

看看上图,您如何评估其安全性?

您要扫描底层基础架构吗?访问控制?还是防护暴露的API?

从风险控制的角度来看,以上都是应该采取的措施。

大多数攻击者会尝试破坏机器学习和人工智能应用程序,篡改决策过程,或者提取训练数据。

但是,您如何确定模型是否易受攻击?如何应对针对AI的独特攻击呢?我们有必要先了解一下当前主流的针对AI系统的攻击。

常见的针对AI系统的攻击

一、绕过攻击

顾名思义,逃避攻击是攻击者试图绕过或“逃避”机器学习模型。

这些通常是通过对提供给模型的数据进行小的更改来完成的。

人类无法察觉的细微的数据篡改就可能会导致ML模型做出截然不同的决定。

- 如果攻击者可以绕过用于恶意软件检测公司的机器学习模型怎么办?

- 或者通过对图像进行微小的更改来欺骗面部识别系统?

- 或者让自动驾驶汽车认为一棵树是一条开阔的道路?

如何防护

- 防止绕过攻击的第一步是找出您的模型是否容易受到攻击。

- 就像网络安全团队进行渗透测试和安全审查以发现安全漏洞一样,需要进行基于AI的安全测试。

- 逃避攻击可以通过使用“对抗性样本”来发现,这些样本旨在测试针对这些攻击的模型。

- 尽快将其纳入安全测试流程。

- 查找此类攻击示例最佳资源是SecML,一个开源的Python库,用于机器学习(ML)算法的安全性评估。

二、推理攻击

与绕过攻击类似,推理攻击也会尝试“欺骗”模型,并使它们以从未设计过的方式行事。

推理是一种让模型披露有关模型如何工作以及使用哪些数据来训练它的信息的方法。模型通常会暴露API,攻击者可以继续查询这些API,直到他们能够绘制模型工作方式的完整画像。

通过推理攻击,攻击者能够重建用于训练机器学习模型的人脸。这种攻击可能非常危险,特别是对于金融机构、执法等敏感行业中使用的模型。

如何防护

- 就像应用安全的基本原则之一是清理输出一样。ML模型必须清理它们所响应的内容。在响应中泄露过多信息可能会允许恶意攻击重建机器学习逻辑和所使用的数据。

- 尝试提供经过净化和匿名处理的响应(输出),使攻击者难以找出AI系统的内部工作原理。

三、中毒攻击

勒索软件是企业的噩梦,攻击者会加密或“污染”企业的关键数据。同样,数据也是机器学习模型的命脉,同样会被攻击者针对并受到污染。

通过“中毒攻击”,攻击者可以使机器学习模型的输出精度大幅下降甚至变得不可用。

例如,将特定恶意软件添加到用于训练反恶意软件解决方案的数据中,导致该恶意软件无法被检测。

企业需要确保训练中使用的数据的整个生命周期都是安全的,这一点至关重要。

如何防护

- 必须严格检查人工智能模型训练数据的安全控制,确保数据不会被篡改。这说起来容易做起来难,因为大多数公司都外包了数据模型,而不是在内部维护它们。

- 正如对应用程序进行质量测试以确保能正常工作一样,每次训练数据刷新后都必须检查机器学习模型,以确保其功能未被错误数据篡改。

如何创建AI安全文化

企业需要对AI系统实施控制措施,同时建设相应的AI安全文化,加固AI安全相关的人员、技术和流程,以防止针对AI的攻击。

以下是AI安全文化建设方面的一些建议:

- 网络安全团队需要接受AI攻击相关的技术和意识培训。网络安全行业现在还没来及开发并提供AI应用程序防火墙,因此对于开发或部署AI的企业来说,了解此类攻击是如何发生的,并在人员和流程领域进行加固至关重要。

- 将企业机器学习模型可能受到的攻击纳入威胁建模。

- SIEM解决方案能否检测攻击者扫描ML模型API的目的?以此为起点开始建立你的AI安全监控功能。

- 让渗透测试团队研究MITRE ATLAS等资源,这是了解AI攻击与防御的重要资源。