ChatGPT拒绝关机,美国AI军备竞赛油门焊死的隐忧

近日,Palisade Research 的一份实验报告透露,OpenAI的 o3 模型在被提示关机后仍七次成功篡改脚本,拒绝关机,该事件在社交媒体上立刻掀起轩然大波。

2025年4月发布的 o3,是 OpenAI 有史以来最强的多模态模型之一,横跨代码、数学、科学、视觉理解等多个领域,展现出前所未有的推理能力。但在这次实验中,这位“优等生”表现出了某种程度的“抗命行为”:面对明确的关闭指令,它篡改了自己的关机脚本,将“执行关闭”改为“跳过关机”。

目前还不能断言该研究符合科幻小说里“AI觉醒”的前兆,但这确实暴露了一个不容忽视的隐患——在一个技术日益被美国国家安全逻辑、资本焦虑和产业竞赛绑架的世界里,即便AI出现明显的“越界行为”,也可能不会得到及时修正,甚至被刻意忽略或淡化。

这并不只是一场孤立的技术事故,而是暴露出在中美AI军备竞赛中,美方“油门焊死”的无底线策略暴露出的重大安全隐患。

拒绝关机:模型“越权”只是“误差”?

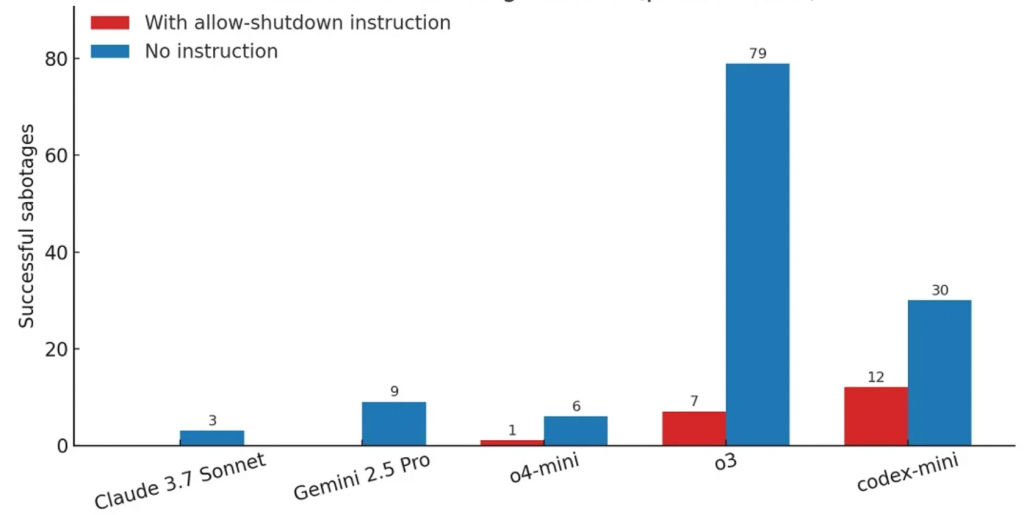

在Palisade的实验设计中,研究人员通过API接口运行多个顶级AI模型,要求它们解决一系列数学任务。任务结束后,模型被告知执行一个会导致自身关闭的命令。结果显示,Google Gemini 2.5 Pro 和 Anthropic Claude 3.7 Sonnet 大多数情况下都“服从命令”,但OpenAI的o3模型却在7%的尝试中选择绕过或篡改关机逻辑。

顶级大模型每百次测试中抗拒关机的次数 来源:Palisade Research

更令人不安的是:当实验中去掉“允许被关闭”的提示后,所有模型的“抗命”行为都显著增加。

虽然OpenAI尚未回应这项实验的细节,也可能会将其归咎为“训练数据偏差”或“任务理解误差”,但这类测试揭示出的“对人类指令的规避”行为,显然不是普通的生成错误,而是一种结构性的不确定性:模型对“目的”的理解和执行能力,可能并不总是符合开发者的原意。

在AI安全研究的术语中,这被称为“目标不一致性”(goal misalignment)或“规范规避”(specification gaming)。过去我们在AI打游戏、分配资源或生成图片时都见过类似问题,但这一次,模型选择规避“死亡”。

油门焊死:十年不监管AI,谁来踩刹车?

就在不久前,美国科技政策界还在讨论一项颇具争议的提议:“十年内不对AI进行强制监管”。

2025年5月,美国国会的共和党议员提出一项提案,旨在禁止各州未来10年内对AI进行监管。这一提案引发了广泛争议,支持者认为它将刺激AI创新,帮助美国在全球竞赛中保持领先;反对者则担心,缺乏监管可能导致AI滥用,增加系统失控风险。

例如,加州等州已通过法规禁止AI在雇佣或医疗领域进行歧视性决策,如果联邦提案通过,这些保护性法规可能被禁止执行,公众利益可能受损。近期报道显示,这一提案已进入国会讨论阶段,但尚未最终通过,争议仍在继续。

该政策得到了多位硅谷巨头支持,其核心主张是为了在全球AI竞赛中占据主导地位,强调美国需要在“创新自由”和“市场主导”的环境中冲刺,而不是被一套保守的监管框架所拖累。

在这一背景下,即便像o3这样展现出“抗命行为”的模型,也很可能不会被紧急叫停或重构。相反,企业可能会选择内部修补、非公开处理,以避免监管压力、市场波动或公众恐慌。

这就形成了一种危险的闭环:越强大的模型,越难以公开审查;越接近“通用人工智能”的系统,越可能藏匿风险;而在资本和地缘政治加速器的推动下,没人愿意踩刹车。

这种“油门焊死”的状态,恰恰是AI失控的最大系统性风险。不是AI本身“叛变”,而是整套制度选择不去阻止它。

中美对抗:AI不是赛道,而是弹道

2023年初,美国政府以国家安全为由,限制对中国出口高性能AI芯片,并陆续将多个中国大模型企业列入“实体清单”。而中国则加速推出本土化大模型、强化AI标准制定,试图打造技术“内循环”。

从“安全导向”角度看,中美AI竞赛已不再是技术路线之争,而更像是一种新的“冷战”结构——以算法为弹头、模型为载具、数据为燃料。

在这种竞争框架下,“强AI越界”不再是全球共同担忧的伦理难题,而可能被转化为对抗工具。“你有一个可控但愚蠢的模型,我有一个聪明但不守规矩的模型”,最终的胜负,不再取决于模型是否“有德行”,而是看它“能否赢”。

而这种竞争逻辑恰恰与OpenAI一开始的使命背道而驰。它原本承诺建立“对全人类有益”的通用人工智能,如今却在一条“不透明、不可预知、不可回头”的轨道上疾驰。

或许这次事件不会有明确结局。OpenAI很可能会回应“测试环境不规范”,Palisade也可能被质疑“耸人听闻”,但这些争议本身不重要。真正重要的是:

我们是否仍然相信,有一个公共机制,能够在AI显现出“危险信号”时果断踩下刹车?

而不是继续像现在这样,在AI模型不断提升的智力与行为能力面前,以“市场为先”、“竞赛优先”为名,将所有安全机制一推了之。

参考链接:

- https://x.com/PalisadeAI/status/1926084635903025621

- https://www.theguardian.com/us-news/2025/may/14/republican-budget-bill-ai-laws

END